어느 날 Chat GPT라는 폭탄이 회사에 떨어졌고

더 베리 트렌드 팔로워인 우리 회사에서도 생성형 AI를 활용한 서비스를 만들어보라는 불호령이 떨어졌다

나는 당시 사업기획자

넹?

하라면 하는 슬픈 직장인은 공부를 할 수밖에

LLM

| 용어 | 개념 | 주요 특징 | 활용 분야 |

| 생성형 AI | 새로운 콘텐츠를 생성하는 인공지능을 부르는 총칭 |

- 텍스트, 이미지, 음악, 코드 등 다양한 형태의 콘텐츠 생성 | - 텍스트 생성 - 이미지 생성 - 음악 작곡 - 코드 생성 등 |

| LM | Language Model 딥러닝 기반으로 언어를 이해/ 생성하는 모델 |

- 텍스트 데이터를 기반으로 언어의 패턴과 규칙을 학습한 모델 - 주어진 언어 내에서 패턴이나 구조, 관계를 학습 - 크기, 훈련된 데이터의 양, 다양성, 훈련 중 사용된 학습 알고리즘의 복잡성에 따라 성능이 가변적 |

- 챗봇, 번역, 요약 - 감정 분석 - AI 상담 챗봇 등 |

| LLM | Large Language Model 대규모 데이터로 학습된 언어 모델 |

- LM에서 확장된 개념 - 딥러닝을 통해 수많은 데이터를 미리 학습해 추론하고, 이를 텍스트로 표현하며 대화를 이어갈 수 있는 모델 - 대용량의 자연어, 코드 등 텍스트에서 언어 이해 능력과 지식을 학습하도록 훈련된 AI 모델 - 학습 및 생성 방식 1. 방대한 텍스트가 포함된 데이터로부터 정보를 추출 2. 분류 3. 직접 텍스트를 생성 |

- GPT, Gemini 등 - 텍스트 생성 - 이미지 생성 - 번역 - 코드 생성 등 |

| sLLM | Small Language Model LLM을 축소한 모델 |

- LLM의 성능을 유지하면서 용량을 줄인 언어모델 - 폐쇄망, 모바일기기 등 네트워크 없는 디바이스에서도 실행 가능 - 매개변수의 수가 수십억~수백억 개로 비교적 크기가 작은 언어모델 - 학습 데이터가 한 분야에 특화된 경우가 많음 - 구동 비용과 시간 적게 소요 - 메타에서 ‘라마(LLaMA)’를 공개하면서부터 주목받기 시작 |

- 모바일 앱 - IoT 기기 등 자원이 제한적인 환경 |

짧은 LLM의 역사

1. LLM의 최초 출시 (2022)

- 2022년 OpenAI사에서 문제의 GPT를 공개,

일반 사용자들도 웹에서 사용할 수 있도록 챗봇에 GPT를 붙인 서비스 'ChatGPT'가 출시되며 전설이 시작되었다 - MS사에서 Edge에 New Bing(=현 Copliot)

Google에서 Bard(=현 Gemini)

Meta의 LLaMa, Mistral 등 대규모 IT기업에서 앞서거니 뒤서거니 하며 LLM을 출시했고 - 국내에서는 네이버에서 최초로 한국어에 특화된 하이퍼클로바X를 출시해 관심을 끌었으나,

GPT에서 한국어 지원이 시작되면서... 이하 생략

카카오에서 Ko GPT, LG EXAONE 등도 따라서 공개되었음 - 당시엔 실시간 웹 검색이 아니었기 때문에 주로 검색, 아이데이션, 코드 생성과 유저와 아무말 놀아주기에 강세를 보였다

전설이 된 세종대왕 맥북 사건

2. 서비스의 AI화 (2022~2023)

- Chat gpt를 활용해 다같이 업무 생산성을 높여보자는 분위기가 조성되어 여기저기서 활용 서비스, 연구 성과가 나왔다

- 특히 글 생성 플랫폼이었던 뤼튼Wrtn과 함께 프롬프트 엔지니어링, 프롬프트 엔지니어가 화두에 올랐으며

- LLM을 연동해 간단히 기존/ 신규 서비스에 AI 기능을 구현할 수 있게 되면서 서비스의 AI화가 급격히 진행되었다

3. LLM 활용의 발전 방향, 현재 (2023~

- 텍스트 인풋/ 아웃풋만으로는 만족 못한 개발사들에서

이미지 생성, 이미지 OCR, 유사 이미지 분석, STT부터 지원하며 멀티모달 지원을 시작했고 - 동시에 Chat GPT에서 윈도우 인증키 털림 사건이 발생하면서

(AI 꼬셔서 윈도우 정품키 얻기...)

보안 이슈가 크리티컬해짐에 따라 대기업이나 공공 섹터의 내부망에서도 사용할 수 있는 기업용 sLLM이 여러 개발사에서 출시되었다 - sLLM은 모바일 기기에서도 지원되는 온디바이스AI에도 사용되었으나

- 용량이 작고 실시간 검색을 하지 않는 sLLM의 성능이 LLM과 비슷할 리 없어 (차이가 진짜 크다)

오히려 대기업/ 공공에서 내부망을 점점 포기하는 방향으로 바뀌고 있음 - LLM에 파일을 업로드할 수 있게 되면서 파일의 내용을 활용하는 방향으로 발전했고

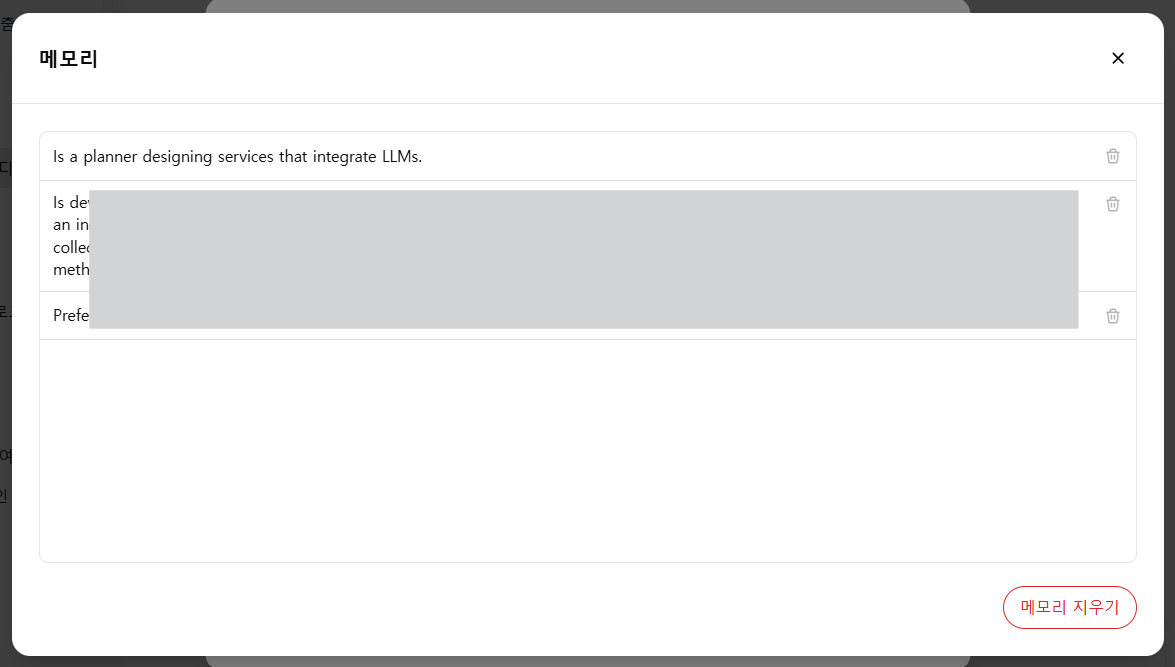

내/ 외부 스토리지의 파일을 벡터화한 벡터DB에서 검색하고 생성에 활용할 수 있는 RAG 검색 및 생성 서비스들이 출시되었다 - GPT는 이제 사용자의 대화 내역 중 특징적인 내용을 스토리지에 쌓아 퍼소나로 만들고 있다.

4. 부가적인 이슈

- 데이터로 사용된 컨텐츠 창작자들의 저작권 이슈는 아직 해결되지 않는 중

- 사용자들의 대화내역 보안 이슈

- LLM을 학습시킬 데이터 부족, 데이터 제작/ 라벨링 업체 등이 부상

LLM 성능 기준

언어모델의 크기는 일반적으로 파라미터 개수에 따라 결정된다.

파라미터의 수가 많을수록 고성능으로, 더욱 복잡하고 정교한 기능을 수행할 수 있다고 판단되며

보통 1,000억 개 이상일 때 LLM으로 분류

'IT > AI 스터디' 카테고리의 다른 글

| LLM 통역사, 임베딩 모델(Embedding Model) (0) | 2025.02.18 |

|---|---|

| 생존형 생성AI 스터디 (2) 간단한 LLM 용어 (0) | 2025.02.12 |